Etienne AUGE

Professeur à l'Université Paris-Sud 11

Directeur Adjoint Scientifique de l'IN2P3/CNRS

Vous trouverez ci-dessous quelques éléments de référence sur la physique du vide et sur la recherche scientifique en cours sur le sujet. Des informations complémentaires peuvent être trouvées sur les sites web.

- Du Centre national de la Recherche Scientifique (CNRS), notamment dans le dossier consacré au début de l’univers (le « Big Bang ») dans la collection Sagasciences.

- De l’Institut National de Physique Nucléaire et de Physique des Particules (IN2P3). Cet institut coordonne au plan national les activités de recherche dans le domaine de l’infiniment petit pour le compte du CNRS et des Universités. Au plan national, il opère en étroite coordination avec l’Institut National des Sciences de l’Univers (INSU) du CNRS, qui traite notamment de l’astrophysique et avec l’Institut de Recherche Fondamentales sur l’Univers (IRFU) du Commissariat à l’Energie Atomique.

- On notera plus particulièrement une série de conférences destinées aux élèves de classes terminales scientifiques (Noyaux Et Particules Au Lycée : NEPAL)

- Du Centre Européen de Recherches Nucléaires (CERN), installé à la frontière franco-suisse près de Genève. Les chercheurs et ingénieurs de l’IN2P3 et de l’IRFU sont impliqués dans de nombreuses collaborations internationales, notamment sur des projets construits au CERN

Parmi les nombreux livres de vulgarisation sur le sujet, on trouve notamment :

- Particules élémentaires et cosmologie : les lois ultimes ? par G. Cohen-Tannoudji et M. Spiro, éditions Le Pommier

- LHC : enquête sur le boson de Higgs par M. Davier, éditions Le Pommier

- Le « big bang » et la physique des deux infinis

La physique des particules élémentaires est reliée très intimement à la cosmologie, science de l’univers dans son ensemble, du fait que les observations astronomiques peuvent jusqu’à présent être interprétées en posant que tous les objets que nous observons sont issus d’une gigantesque explosion qui a eu lieu il y a 13,7 milliards d’années. Aux tout premiers instants de l’univers, la matière de notre univers était extraordinairement concentrée et chaude, et ses constituants élémentaires se heurtaient avec une violence extrême, comparable aux collisions produites dans les accélérateurs de particules comme le LHC. Ce scénario de « big bang » permet de relier l’infiniment petit étudié actuellement en laboratoire, l’infiniment petit des tout premiers instants de l’univers et l’infiniment grand de l’univers actuel. On peut donc parler d’une « physique des deux infinis ».

Ce domaine de la science ambitionne de décrire dans le cadre d’un modèle avec un petit nombre de lois une très grande variété d’objets, du minuscule noyau atomique au gigantesque amas de galaxies. On verra ci-dessous que cela nécessite une définition précise du vide. Quand on s’intéresse au vide, il est particulièrement important de bien séparer ce qui est du domaine de la métaphysique, qui peut éventuellement nourrir l’intuition d’un physicien, et ce qui est du domaine de la physique, c'est-à-dire de la description précise et cohérente des observations dans le cadre d’un modèle dont les lois peuvent être exprimées mathématiquement pour en extraire des prédictions quantitatives, corroborées ou pas par de nouvelles observations. Contrairement à ce que le texte ci-dessous risque de laisser croire, la physique ne se réduit pas à quelques grandes idées séduisantes pour l’intuition : déduire toutes les conséquences d’une idée pour s’assurer qu’elle n’est pas contredite par des observations représente un énorme travail indispensable de même qu’il est indispensable de pouvoir situer précisément cette nouvelle idée dans le cadre théorique du moment, ne serait-ce que pour s’assurer qu’elle est réellement nouvelle.

- L’énergie : un concept fondamental

Le dogme actuel repose sur le concept d’énergie, une quantité qui caractérise la capacité d’un objet à évoluer spontanément au cours du temps (en transférant cette énergie à son environnement ou à un autre objet). Un objet totalement isolé (et qui ne peut donc pas transmettre son énergie), ou un objet dont l’énergie est minimale, ne peuvent avoir qu’une évolution triviale (on dit un état d’équilibre). Ils ne peuvent alors quitter cet état d’équilibre que si une intervention extérieure leur amène un surcroît d’énergie. Des lois générales doivent rendre compte de façon cohérente des multiples formes apparentes de l’énergie (par exemple énergie de mouvement –énergie cinétique- que la boule de pétanque lancée va transférer à une autre boule de pétanque initialement immobile, l’énergie électrique, transformée en énergie cinétique par un moteur électrique, l’énergie chimique qui fait que deux composants chimiques mis en contact vont réagir plus ou moins violemment….)

On doit à J.P. Joule d’avoir démontré en 1845 que la chaleur est une forme de l’énergie : lorsqu’on lui communique de l’énergie en l’agitant, l’eau résiste à cette mise en mouvement (du fait de sa propriété de viscosité) et s’échauffe en proportion de l’énergie fournie.

- Energie et masse

On doit à A. Einstein d’avoir postulé en 1905 que la masse est (à un facteur c² près) une forme d’énergie : E=mc² où c – pour célérité- représente la vitesse de propagation de la lumière dans le vide. Par définition, la masse caractérise l’inertie d’un objet matériel, c'est-à-dire sa capacité à résister lorsqu’on essaye de le mettre en mouvement. Si on souhaite obtenir une accélération donnée pour un objet (par exemple passer de 0 à 100 km/h en un temps donné), alors il faut exercer une force d’autant plus grande que la masse de l’objet est grande.

Par une coïncidence troublante, la masse caractérise aussi la sensibilité d’un objet à la présence d’un autre objet massif (et donc la sensibilité de l’objet à la gravitation). Pour construire la théorie de la relativité générale en 1915, Einstein a posé cette coïncidence entre la masse inerte et la masse pesante comme principe (le principe d’équivalence). Ce principe dit qu’un observateur installé dans un ascenseur qui descend en chute libre (sous l’effet de la pesanteur terrestre) a l’impression de flotter en apesanteur dans cette cabine. L’effet de la pesanteur, bien réel pour un observateur extérieur à l’ascenseur, a disparu lorsqu’on choisit le bon référentiel d’observation (c'est-à-dire si on se réfère à la cabine d’ascenseur).

- Vide et masse

A partir d’énergie, on peut donc fabriquer de la masse, c'est-à-dire de la matière (inerte et pesante). On ne peut donc pas définir le vide comme l’absence de matière (et d’antimatière, cf ci-après), quelle que soit sa forme. En revanche, on peut essayer de définir le vide comme un état d’énergie minimale, dans la mesure où il est assez intuitif que cet état d’énergie minimale ne peut pas contenir de matière (sinon, il « suffirait » théoriquement de l’enlever pour obtenir un état d’énergie moindre, en contradiction avec l’hypothèse d’énergie minimale). Le vide ainsi défini ne contredit pas l’intuition. On peut appliquer cette définition à un domaine limité de l’espace.

A parte sur l’antimatière

Il est intuitivement naturel d’associer le concept de masse à la matière. Il faut cependant noter qu’il s’applique tout autant à l’antimatière. On peut en première approximation considérer l’antimatière comme de la matière pour laquelle toutes les charges électriques auraient changé de signe : ainsi, aux électrons de la matière, portant une charge électrique négative correspondent des antiélectrons (aussi appelés positons) ayant les mêmes propriétés mis à part une charge électrique positive. Les observations astronomiques n’ont jamais permis d’observer de l’antimatière. Au contraire, lorsqu’on transforme de l’énergie en masse, on fabrique le plus souvent autant de matière que d’antimatière. On peut par exemple fabriquer simultanément un électron et un antiélectron, qui peuvent éventuellement s’annihiler entre eux pour redonner de l’énergie sous la forme de rayonnement électromagnétique (lumière).

- Du vide partout et nulle part

Notre univers n’est pas vide (on en fait partie… et notre modèle cosmologique du moment nous dit que, même dans les endroits les plus reculés du cosmos, loin de toute galaxie, on trouve encore quelques milliers de particules par mètre cube), mais on pourrait imaginer un autre univers ayant les mêmes lois de la physique et totalement vide. Il n’est pas facile de démontrer qu’une zone de l’espace ne contient aucune matière : il peut rester de petits grains de matière solide, de petites gouttes de liquide, des traces de gaz…Imaginer un vide parfait en observant un vide approximatif ne va pas de soi.

Avec la définition du vide comme un état d’énergie minimale auquel on peut apporter un surcroît d’énergie, le vide apparaît comme l’environnement fondamental : ayant amené de l’énergie dans une zone vide, on peut faire apparaître de la masse (matière et antimatière) au sein de cette zone vide.

Cette réflexion est fortement corroborée par moult observations : un atome est formé d’un noyau « dense » autour duquel gravitent des électrons : il ressemble au système solaire en beaucoup plus petit (le soleil a la place du noyau et les planètes à la place des électrons : entre ces objets : du vide. Le noyau lui-même, réputé extrêmement dense (si on empilait uniquement des noyaux « bien tassés », on obtiendrait des masses de plusieurs milliards de tonnes dans un dé à coudre). Pourtant, un noyau est formé de protons et de neutrons, et ceux-ci sont formés de quarks, qui sont des objets au moins 10 000 fois plus petits que le proton. Le volume d’un noyau est donc principalement vide.

C’est E. Rutherford qui, en 1911, a découvert que des particules alpha (des noyaux d’Hélium) traversaient sans encombre une feuille d’Or, seul un noyau sur plus de 10 000 était dévié (parce qu’il avait heurté un noyau atomique en traversant la feuille).

Attention au vocabulaire : un volume d’un mètre cube n’importe ou dans notre univers n’est pas vide puisqu’il comporte toujours au moins quelques milliers de particules (et quelquefois beaucoup plus), mais l’énorme majeure partie de ce volume est du vide puisque la matière n’occupe en réalité qu’une infime fraction du volume : ses constituants élémentaires « baignent dans le vide ».

- Premières propriétés du vide

Ayant ainsi posé le vide comme un état fondamental de la nature (que ce soit notre univers ou un autre univers potentiel), on ne peut développer un modèle qu’en postulant les propriétés de ce vide :

- il est invariant par translation : dans un espace vide infini, les lois de la physique sont les mêmes en tout point. On en déduit que si, à partir d’énergie, je crée de la masse en un point de cet espace, il se passera la même chose quel que soit le point choisi. Un raisonnement un peu complexe, conséquence du principe de moindre action – un système cherche toujours à minimiser son énergie – relie cette invariance à la conservation de l’énergie (on utilise un théorème dù à la mathématicienne allemande Emmy Noether en 1908).

- dans le vide, on observe la même chose dans toutes les directions de l’espace (isotropie du vide). Le théorème de Noether permet d’en déduire la conservation du moment cinétique : si un objet isolé tourne sur lui-même, il continuera indéfiniment…).

- conformément à l’observation, que le vide ne contient aucune source d’interaction (pas de charge électrique, pas de masse – non pas en tant que matière, c’est déjà exclu, mais en tant que source de pesanteur-) : d’après ce postulat, un objet tout seul dans le vide est isolé (heureusement ! ).

Et nous avons donc un vide tout à fait satisfaisant….MAIS

- Ether et horreur du vide

On sait bien que la nature a horreur du vide….à moins que ce ne soient les physiciens qui en aient horreur…

Depuis l’antiquité grecque, on a observé deux phénomènes troublants : l’attraction électrique (un morceau d’ambre frotté – cela fonctionne aussi avec un morceau de plastique- peut attirer de petits bouts de papiers) et l’attraction magnétique (une pierre de magnésie peut en faire bouger une autre à distance). Dans les deux cas, deux objets interagissent à distance. Une saine intuition dit pourtant qu’à chaque forme d’interaction doit correspondre un vecteur…

Par exemple, les sons ont besoin de l’air pour se propager : la source sonore entraîne une vibration de l’air, qui se propage de proche en proche jusqu’à arriver à des oreilles. Si on retire progressivement l’air entre la source et l’oreille, le son arrive de plus en plus atténué et on peut aisément extrapoler que, si on retirait tout l’air, le son ne se propagerait plus du tout. Le son ne se propage donc pas dans le vide.

En revanche, les phénomènes électriques et magnétiques (on sait depuis J.C. Maxwell en 1864 que ces deux phénomènes sont deux aspects d’une même interaction, qui se manifeste aussi par la lumière) se propagent dans le vide : lorsqu’on pompe dans une enceinte, on observe que la lumière s’y propage toujours aussi bien (voire mieux). On a donc inventé l’éther, ce fluide « subtil » en lui assignant la propriété essentielle d’être le vecteur des phénomènes électromagnétiques. Il faut alors admettre que lorsqu’une pompe évacue l’air, elle laisse l’éther en place, ce qui n’est pas très intuitif.

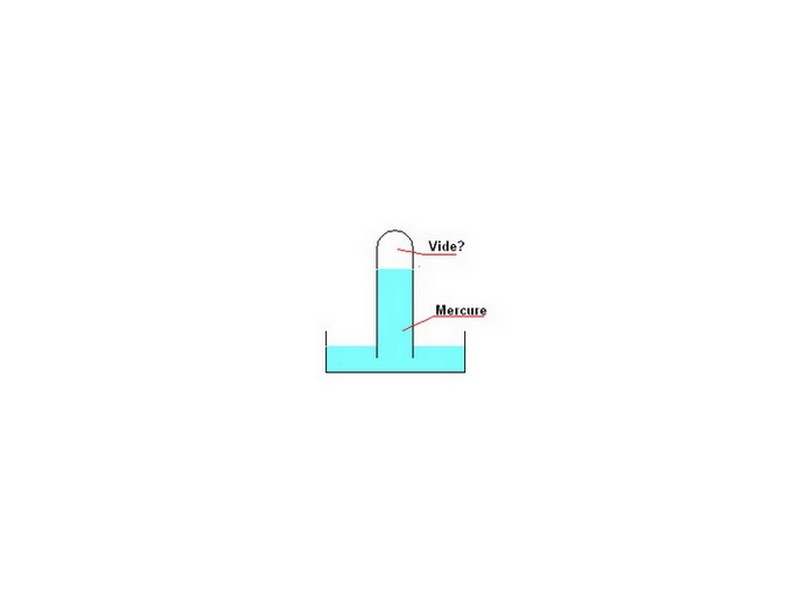

A parte : le baromètre de Torricelli (1644)

|

Lorsqu’on remplit une éprouvette de liquide, par exemple du mercure, liquide particulièrement dense, et qu’on place cette éprouvette verticalement au dessus d’une cive remplie du liquide, de façon que l’orifice de l’éprouvette soit immergé dans la cuve, on observe que le liquide ne s’écoule pas totalement hors de l’éprouvette. Le fluide situé dans l’éprouvette au dessus du liquide ne peut avoir pénétré de l’extérieur. En 1648, B. Pascal n’a pas craint de postuler qu’il s’agissait de vide, mais il était difficile alors de comprendre par quelle propriété ce fluide arrivait à retenir du liquide dans l’éprouvette Avec les concepts développés indépendamment par Torricelli et Pascal, on dit que l’air ambiant exerce sur la surface du liquide de la cuve une pression (la pression atmosphérique), qui empêche le niveau du liquide de s’élever dans la cuve, ce qui empêche donc le liquide de quitter l’éprouvette.

|

- Principe de relativité

L’ hypothèse de l’éther a une conséquence fondamentale : la lumière se déplace toujours par rapport à l’éther, comme le son se déplace toujours par rapport à l’air ambiant, que cet air ambiant soit immobile ou en mouvement par rapport à la source de son ou à l’oreille. Mais J.C. Maxwell avait déjà remarqué que les équations supposées décrire la propagation de la lumière étaient incompatibles avec les équations usuelles d’un mouvement : il y avait donc une difficulté théorique. De plus, en 1887, A. Michelson et E. Morley ont mesuré très précisément la vitesse de la lumière issue de différentes étoiles et montré que cette vitesse était toujours la même. Or, le mouvement de la terre autour du soleil, et donc par rapport à l’éther aurait du entraîner des différences de vitesse apparente….S’ajoute donc une difficulté d’observation, qui choque l’intuition de l’époque. A. Einstein résoudra ce paradoxe en 1905 en postulant que la vitesse de la lumière entre une source lumineuse et un observateur est la même dans tous les référentiels (non accélérés). Il en résulte que les lois habituelles de la mécanique « classique » (« de Galilée ») ne sont en réalité que des approximations, qui cessent d’être valables lorsque des objets se déplacent à des vitesses proches de celle de la lumière, ou lorsque l’on s’intéresse à des mesures de très grande précision. L’hypothèse de l’éther est incompatible avec la théorie d’Einstein, et on se retrouve donc à nouveau sans vecteur pour l’interaction électromagnétique….

- Théorie quantique et Mesure

Arrive la seconde grande révolution du XXème siècle avec la relativité : la théorie quantique. La théorie de Maxwell prédit qu’un atome ressemblant à un système solaire miniature (modèle du à N. Bohr en 1913) ne peut pas exister : les électrons doivent se rapprocher petit à petit inexorablement du noyau. Pourtant, ce modèle est séduisant à beaucoup d’autres égards, d’autant plus qu’on n’arrive pas à développer d’autres modèles viables.

Par ailleurs, on sait qu’un corps chauffé émet de la lumière (cela lui donne une belle couleur rouge, virant progressivement au jaune et au blanc lorsque la température augmente). En 1900, en essayant de calculer le spectre de couleur, Max Planck tombe sur une incohérence : selon son calcul, l’énergie lumineuse émise est infinie, ce qui ne peut pas être vrai.

La théorie quantique va résoudre ces deux problèmes en reconsidérant le processus de mesure. En effet, la mesure d’un système très petit par un appareil de mesure de taille « humaine » perturbe nécessairement ce système. Lorsqu’on mesure deux caractéristiques d’un même objet (avec deux appareils), alors les résultats obtenus dépendent de l’ordre dans lequel on a effectué ces mesures. Voila qui est très gênant pour extraire des propriétés intrinsèques des objets à partir des observations. L’idée a été d’inclure le processus de mesure dans la théorie. L’objet d’étude est décrit par un objet mathématique dont on connaît quelques propriétés, et l’opération de mesure est décrite par une opération mathématique effectuée sur l’objet mathématique, qui fournit un résultat assimilable au résultat de mesure. Le souci est qu’en général cette opération mathématique fournit toute une gamme de résultats, qu’on interprète comme des résultats possibles de la mesure. On abandonne ici l’idée de lois déterministes pour adopter un point de vue probabiliste : une mesure peut a priori donner plusieurs résultats possibles (comme la mesure perturbe le système, l’idée de faire plusieurs fois la même mesure n’a aucun sens, et cette théorie n’est en réalité pas contraire à l’intuition)

- Interactions et particules virtuelles

Les relations d’incertitude d’Heisenberg (1925) sont une conséquence directe de la théorie quantique. Elles affirment en particulier qu’on ne peut mesurer l’énergie d’un système avec une précision très grande qu’en y passant un temps très grand. Lorsqu’on effectue une mesure sur un intervalle de temps court, il est en principe impossible d’obtenir une précision meilleure qu’une certaine limite. Dans cette limite, on ne peut donc pas vérifier si l’énergie est bien conservée ou pas, et la question de la conservation stricte de l’énergie doit donc être reconsidérée.

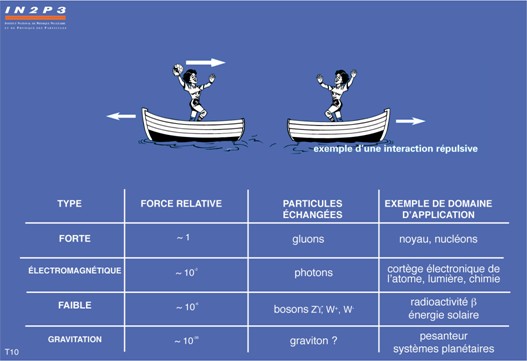

Il en résulte qu’on peut interpréter toutes les formes d’interaction comme un échange de particules, qui sont alors les vecteurs de l’interaction. Une image simple permet d’illustrer le cas particulier d’une interaction répulsive entre deux objets. Le concept de force est théorique : on dit qu’une force répulsive s’exerce entre deux objets (ou que l’un des objets exerce une force répulsive sur l’autre) si ces deux objets s’éloignent spontanément (on dit aussi que l’ensemble des deux objets possède de l’énergie potentielle).

Imaginons deux personnages, chacun sur son bateau initialement immobile. Le premier personnage lance un ballon en direction du second. Sous l’effet de cette action, son bateau se déplace dans la direction opposée au lancement. Lorsque le second personnage reçoit le ballon, son bateau s’éloigne à son tour de l’autre bateau. Ainsi les deux bateaux s’éloignent l’un de l’autre, comme s’ils se repoussaient. Remarquons aussi que, pour un observateur qui ne verrait pas le ballon, l’énergie n’est pas conservée pendant tout le temps de trajet du ballon, puisque, pendant cet intervalle, seule le premier bateau s’est mis en mouvement, sans contrepartie de la part de l’autre bateau.

Les ballons sont les particules vecteurs de l’interaction. Du fait de leur durée de vie limitée et du fait qu’elles ne sont pas directement détectées, on les appelle particules virtuelles.

De plus, la théorie n’interdit pas, et donc permet, que la densité d’énergie du vide fluctue. Pendant un court instant, elle permet à un photon virtuel échangé entre deux particules en interaction électromagnétique de se transformer en une paire particule-antiparticule, par exemple électron-positon, qui redevient presque immédiatement un photon. Cet effet modifie très légèrement les caractéristiques de l’interaction électromagnétique, et est aussi responsable de l’effet Casimir (voir ci-dessous)

Finalement, lorsqu’on a posé, par principe, que l’interaction électromagnétique (en particulier la lumière) se propage dans le vide, il est satisfaisant de se dire que le vide contient des particules chargées qui, bien que fugitives, ont toutes les propriétés pour transmettre cette interaction.

- Effet Casimir

L’effet Casimir est la seule preuve expérimentale directe des fluctuations quantiques du vide : on observe que deux plaques planes conductrices (au sens de l’électricité), placées dans le vide et maintenues à basse température, s’attirent mutuellement avec une force très faible. Pour que le vide soit parfait, on place les deux plaques dans une enceinte avec une pression résiduelle de gaz aussi faible que possible, sans lumière, et à température quasi-nulle pour que les deux plaques n’émettent quasiment pas de lumière par elles-mêmes. Dans ces conditions, aucun élément extérieur n’est susceptible d’exercer la moindre force sur les plaques. En revanche, par fluctuation tolérée par les relations d’incertitude de Heisenberg, le vide peut émettre un rayonnement électromagnétique, aussitôt réabsorbé. Cependant, comme les plaques sont conductrices, les champs électriques et magnétiques sont nuls sur leur surface. Il en résulte que certaines fluctuations du vide peuvent exister à l’extérieur des deux plaques, mais pas entre les deux plaques. Du fait de cette disparité, le vide exerce sur les deux plaques une force qui tend à les rapprocher. En 1948, H. Casimir a prédit quantitativement cette force, qui a ensuite été mesurée pour la première fois avec une précision significative, à la valeur correcte, en 1978.

- Symétrie, Masse et boson de Higgs

Une propriété importante d’un environnement en général, et du vide en particulier concerne ce qui est improprement appelé « brisure spontanée de symétrie ». Ce phénomène est bien connu des constructeurs d’ouvrages d’art sous le nom de « flambage des poutres ». Soit une brindille parfaitement rectiligne, de forme idéalement cylindrique. Si on la comprime en exerçant une force selon son axe de symétrie, on a un problème qui possède une symétrie axiale. Il n’y a pas plus de raison que la brindille se déforme vers l’Est, l’Ouest, le Sud ou le Nord, et elle devrait donc « normalement » demeurer rectiligne. L’expérience montre que la brindille va cependant se plier et ne plus être rectiligne. Le problème a perdu sa symétrie car la brindille a choisi, de manière aléatoire en apparence, de plier dans une certaine direction. On considère que, bien que le problème soit symétrique, il y a une instabilité et il suffit d’une perturbation infinitésimale de l’environnement pour que la brindille choisisse une direction pour plier et évacuer l’énergie qu’on lui communiquait en la comprimant.

Les matériaux ferromagnétiques fournissent un autre exemple de brisure spontanée de symétrie : lorsqu’on les chauffe au-delà de la température de Curie (770 °C pour le fer), ils ne présentent aucune aimantation. En revanche, l’aimantation apparaît brusquement lorsqu’ils sont refroidis en dessous de cette température. D’une situation dans laquelle toutes les directions sont équivalentes (à haute température), on passe à une situation dans laquelle le matériau a développé une aimantation dans une direction particulière, choisie aléatoirement. En d’autres termes, si on répète cette expérience de refroidissement un très grand nombre de fois, chaque direction aura au final été choisie autant de fois que les autres, ce qui prouve qu’une symétrie demeure, même si, pour chaque expérience individuelle, elle semble avoir disparu.

On en revient au vide : bien que l’interaction nucléaire faible (responsable du phénomène de radioactivité) et l’interaction électromagnétique (responsable de la lumière) soient très dissemblables en apparence, Glashow, Weinberg et Salam ont montré en 1967 qu’il suffisait d’une perturbation infinitésimale du vide pour que, partant d’une théorie unique, on arrive à ces deux phénomènes. Ils prouvaient par là que deux phénomènes pouvaient être expliqués par les mêmes lois fondamentales. Higgs et d’autres ont parachevé le travail en remarquant que cette perturbation du vide lui donne en même temps la propriété de s’opposer à la mise en mouvement des particules : lorsqu’on place une particule dans le vide, et qu’on essaye ensuite de la mettre en mouvement, la perturbation du vide (qu’on appelle « champs de Higgs ») s’y oppose : on interprète ce phénomène en disant que la particule possède une inertie, caractérisée par ce qu’on appelle sa masse. En d’autres termes, selon cette théorie, les masses des particules proviennent de leurs interactions avec le champ de Higgs du vide. Si cette théorie est correcte, alors si on fournit une énergie suffisante, le champ de Higgs peut se matérialiser sous la forme d’une particule non encore observée : le boson de Higgs. Mettre en évidence le boson de Higgs est l’un des buts principaux du LHC.

Conclusion

En conclusion, on ne peut pas à proprement parler de « physique du vide » mais plutôt dire que pour toutes les recherches fondamentales, dans le domaine des particules élémentaires comme dans celui de la cosmologie (physique des deux infinis), il est impératif de définir le concept de vide d’une manière unique, cohérente avec le cadre théorique utilisé.